NVIDIA vGPUのテクノロジー概要

NVIDIA vGPUは、ソフトウェアによってサーバーに搭載されたGPUのメモリを仮想的に分割、複数台の仮想マシンで高いコア性能を効率的に利用することができます。また、用途やアプリケーションによって柔軟な構成をとることが可能です。この技術はVDI(仮想デスクトップ)環境で容易に使えるものとなり、GPUの高いパフォーマンスをあらゆる業務に広げていくことに貢献します。

GPUと仮想マシンを1対多の関係へ

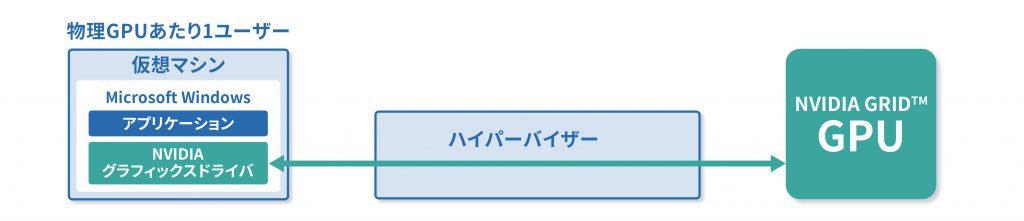

VDI環境でもGPUを使いたいというニーズは2013年頃から高まり始め、NVIDIAではホストサーバーに搭載されたGPU(NVIDIA Quadro)カードをパススルーで任意の仮想マシンに割り当てる仕組みを提供しました。しかし、当時のホストサーバーに搭載可能なGPUカードは最大でも2枚程度で、GPUを利用可能な仮想マシンの数もこの枚数に縛られていました。

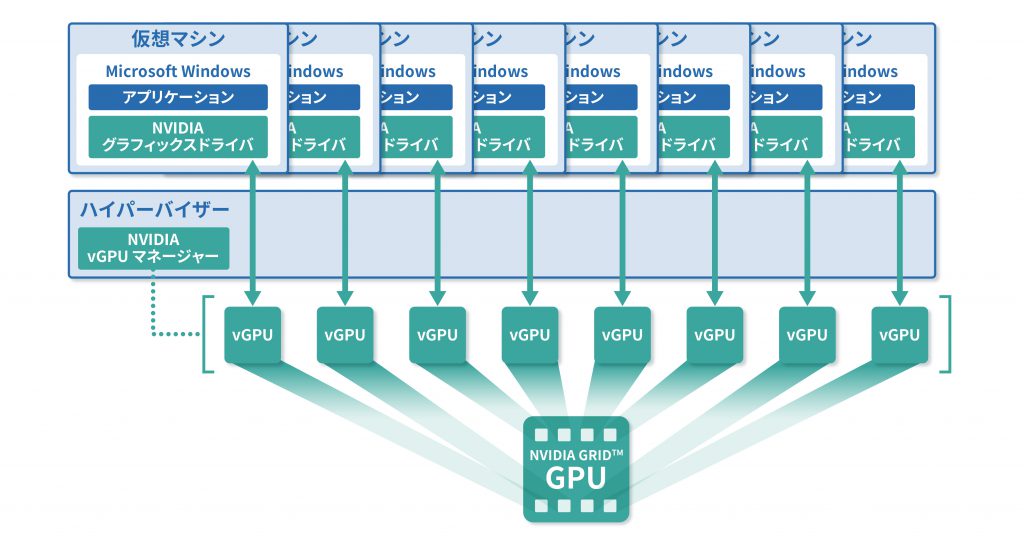

そこで年々進化し、高速化していくGPUのリソースをより効率的に利用できるようにするため、仮想GPUソリューション「NVIDIA vGPU」が開発されました。NVIDIA vGPUは、ホストサーバーに搭載された物理GPUのメモリをソフトウェアで仮想的に分割、複数の仮想マシンで高いコア性能を共有できる仮想 GPU を作成します。これによりGPUと仮想マシン(ユーザー)を1対1の関係から1対多の関係へと改めて、柔軟に割り当てることが可能となります。

また、NVIDIA vGPUのソフトウェアには仮想マシンごとのグラフィックスドライバーも提供されており、仮想マシンに仮想GPUを割り当てた場合も物理PCやワークステーションなどと同等の操作性を実現します。

GPUパススルーとGPU仮想化の違い

多彩なGPU製品がNVIDIA vGPUに対応

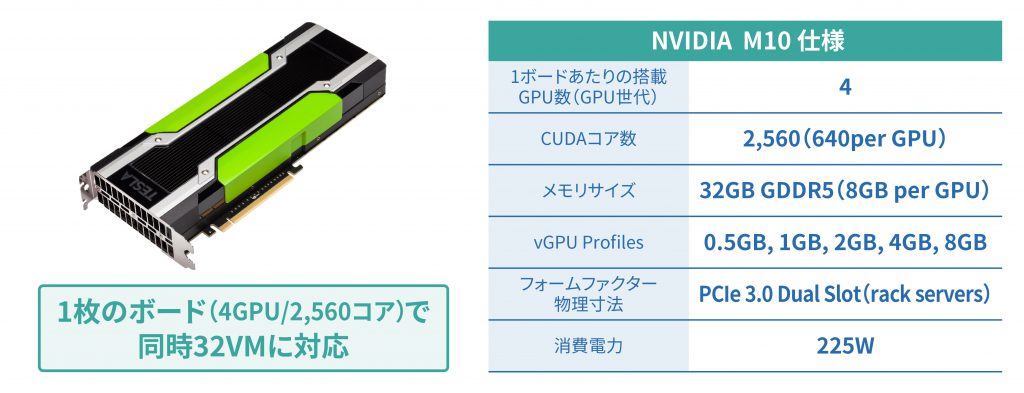

現在NVIDIAでは、オフィスユーザー向けのNVIDIA M10から、オフィスやCADなど多様なワークロードに対応するNVIDIA T4、CADやグラフィックスなどエンジニアリング業務向けのNVIDIA A40、データセンター向けのNVIDIA A100まで、多彩なGPUラインナップのNVIDIA vGPU対応を進めています。

特にヴイエムウェアなどのベンダーが提供するVDIソリューションとNVIDIA vGPUとの連携により、業界トップクラスの仮想マシンの集約密度を実現するのがNVIDIA M10です。具体的には、ボード1枚あたりに搭載されている4GPU/2,560コアを仮想化し、最大32人のユーザー(1GBプロファイル)に割り当て、高度なエクスペリエンス(体感性能)を提供することが可能です。

なお、多くのハードウェアベンダーから、NVIDIA vGPU認証サーバーが提供されています。このため煩雑な事前検証などの作業を行うことなく短期間でVDI+NVIDIA vGPUのインフラを構築し、運用を開始することができます。

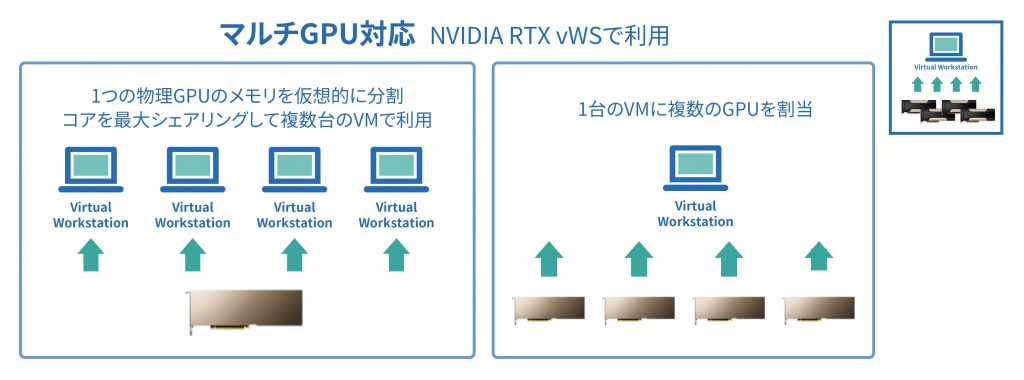

1台の仮想マシンに複数の GPU を割り当てる

NVIDIA vGPUのテクノロジーは現在も絶え間ない進化を続けています。ここまで述べてきたNVIDA vGPUのメリットは、そのリソースを分割して複数のユーザーで共有して有効活用するものでしたが、一方で現在ではエンジニアリング分野のシミュレーションやディプラーニングを用いた画像認識や将来予測など、より多くのGPUパワーが要求されるワークロードも増大しています。

そこでNVIDIAでは、逆に複数のボード上のGPUをまとめて1台の仮想マシンに割り当てることができる「マルチGPU」という機能を提供しています。NVIDIA RTX 仮想ワークステーションソフトウェアによって実現されたこの機能により、ハイエンドのエンジニアリングワークステーションに匹敵するGPU性能をVDI上で利用することが可能となります。

実際にこのマルチGPUを利用しているユーザーからは「リニアに近いパフォーマンススケーリングのおかげで、超高速でデザインを繰り返すことが可能となった」、「場所にとらわれることなくレンダリングを迅速に実行し、よりリアルなグラフィックスを制作できるようになった」といった声が上がっています。

なお、大規模なGPUを必要とするワークロードが完了したあと、再びGPUを分割して複数のユーザーに割り当てるといった柔軟な運用も可能です。

NVIDIA vGPU付仮想マシンのライブマイグレーション

NVIDIA vGPUにおける技術的なブレークスルーとして、もう1つ取り上げておきたいのが、NVIDIA vGPU付仮想マシンのライブマイグレーションです。

VDI環境でもホストサーバーの保守管理や更新、仮想マシンの配置見直しなどのライフサイクル管理は不可欠ですが、NVIDIA vGPU付の仮想マシンは容易に動かすことができませんでした。大規模な並列アーキテクチャーを備えたGPUの何千ものコア、エンコード デコードエンジン、およびフレームバッファを移行する必要があり、膨大なダウンタイムが発生してしまうからです。

しかし、今ではライブマイグレーションにも対応しており、データを消失することなく、最小のダウンタイムで稼働中の仮想マシンを別のホストサーバーに移動することを可能とします。ワークロードの移行中もユーザーはそのアプリケーションにアクセスし続けることができ、作業が中断されることはありません。

一方でシステム管理者もダウンタイムのスケジュールをユーザー部門と事前に調整することなく、ハードウェア交換やアップグレード、ソフトウェア更新などのホストサーバーの保守が急に必要となった場合も迅速に対応することが可能となります。